- 27 Dec, 2025 *

斯坦福 HAI:AI 透明度正在下降

- 原文链接:Transparency in AI is on the Decline

- 来源:Shana Lynch

一项新研究显示,AI 行业正在隐瞒关键信息。

AI 公司乃至整个 AI 行业从未像现在这样重要。包括 Google 和 Meta 在内的七家老牌 AI 公司占标普 500 指数权重的 35% 以上。像 OpenAI 和 Anthropic 这样的初创公司已成为历史上最有价值的私营公司。数十亿人正在使用基础模型(Foundation Models)搜索信息、辅助写作,并生成图像、视频和音频。但是,这些构建我们共同未来的公司究竟有多透明?

今天,我们这支由来自斯坦福、伯克利、普林斯顿和麻省理工学院的研究人员组成的团队,发布了2025年基础模型透明度指数(Foundation Model Transparency Index, FMTI),这是该年度指数的第三版。我们发现,自 2024 年以来透明度有所下降,各公司在透明度程度上分歧巨大。

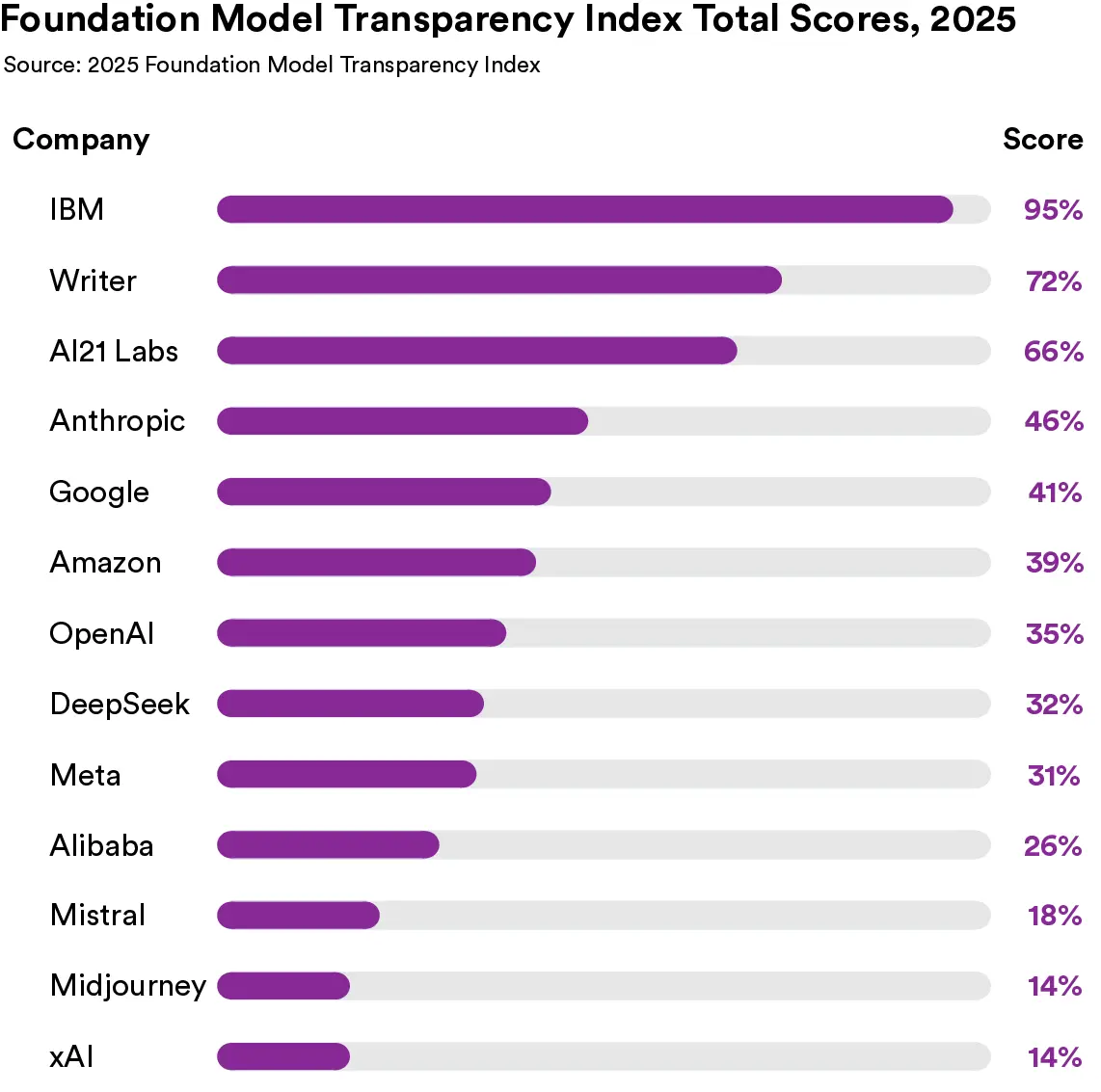

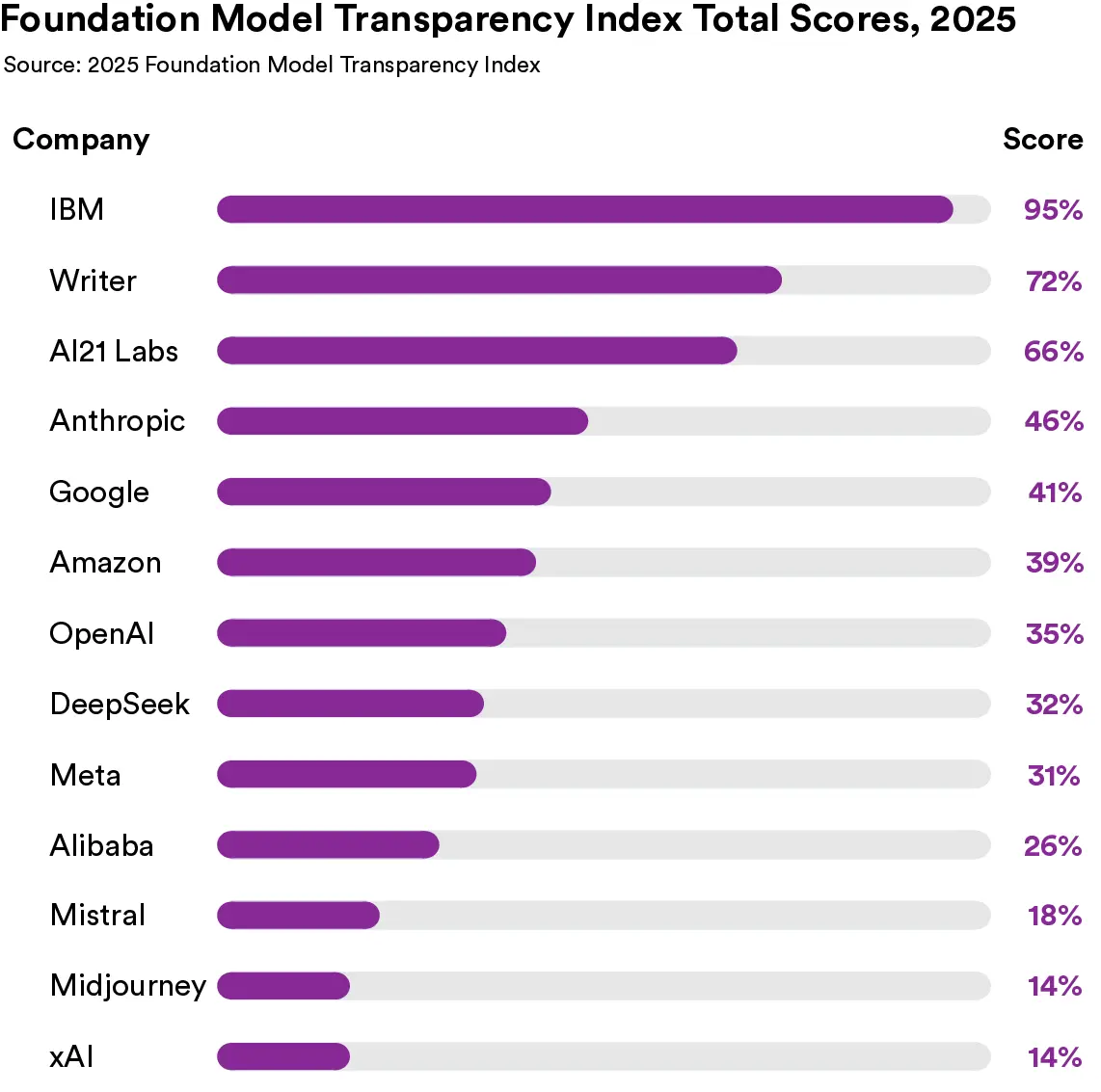

2025 FMTI 对 13 家公司进行了评分,发现各公司在优先考虑透明度的程度上存在巨大差异。

2025 FMTI 对 13 家公司进行了评分,发现各公司在优先考虑透明度的程度上存在巨大差异。

基础模型透明度指数是一份年度报告,全面评估主要 AI 公司及其旗舰模型的透明度。每家公司的评分采用 100 分制,涵盖训练数据、风险缓解和…

- 27 Dec, 2025 *

斯坦福 HAI:AI 透明度正在下降

- 原文链接:Transparency in AI is on the Decline

- 来源:Shana Lynch

一项新研究显示,AI 行业正在隐瞒关键信息。

AI 公司乃至整个 AI 行业从未像现在这样重要。包括 Google 和 Meta 在内的七家老牌 AI 公司占标普 500 指数权重的 35% 以上。像 OpenAI 和 Anthropic 这样的初创公司已成为历史上最有价值的私营公司。数十亿人正在使用基础模型(Foundation Models)搜索信息、辅助写作,并生成图像、视频和音频。但是,这些构建我们共同未来的公司究竟有多透明?

今天,我们这支由来自斯坦福、伯克利、普林斯顿和麻省理工学院的研究人员组成的团队,发布了2025年基础模型透明度指数(Foundation Model Transparency Index, FMTI),这是该年度指数的第三版。我们发现,自 2024 年以来透明度有所下降,各公司在透明度程度上分歧巨大。

2025 FMTI 对 13 家公司进行了评分,发现各公司在优先考虑透明度的程度上存在巨大差异。

2025 FMTI 对 13 家公司进行了评分,发现各公司在优先考虑透明度的程度上存在巨大差异。

基础模型透明度指数是一份年度报告,全面评估主要 AI 公司及其旗舰模型的透明度。每家公司的评分采用 100 分制,涵盖训练数据、风险缓解和经济影响等主题。今年的指数表明,全行业的透明度水平很低。在 100 分制下,这些公司的平均得分仅为 40 分。

尽管平均分很低,但各公司的做法差异很大。出现了三个梯队:表现最好的得分约 75 分,中游水平约 35 分,低分梯队平均约 15 分。

在榜首,IBM 获得了该指数历史最高分 95/100。难能可贵的是,IBM 开创了行业先例,披露了许多其他公司未曾分享的指标信息。例如,IBM 是唯一一家提供足够细节供外部研究人员复制其训练数据的公司,并允许审计员等外部实体访问这些数据。

另一方面,xAI 和 Midjourney 的得分为 14/100,是该指数历史上最低的。它们没有分享任何关于构建模型所用数据、模型相关风险或风险缓解措施的信息。总体而言,我们评估的这十三家公司几乎没有分享关于构建和部署基础模型的环境或社会影响的信息。

这些模式表明,当前的透明度实践主要取决于个别公司是否选择优先考虑透明度,而不是行业范围内对透明度的激励(或抑制)机制。

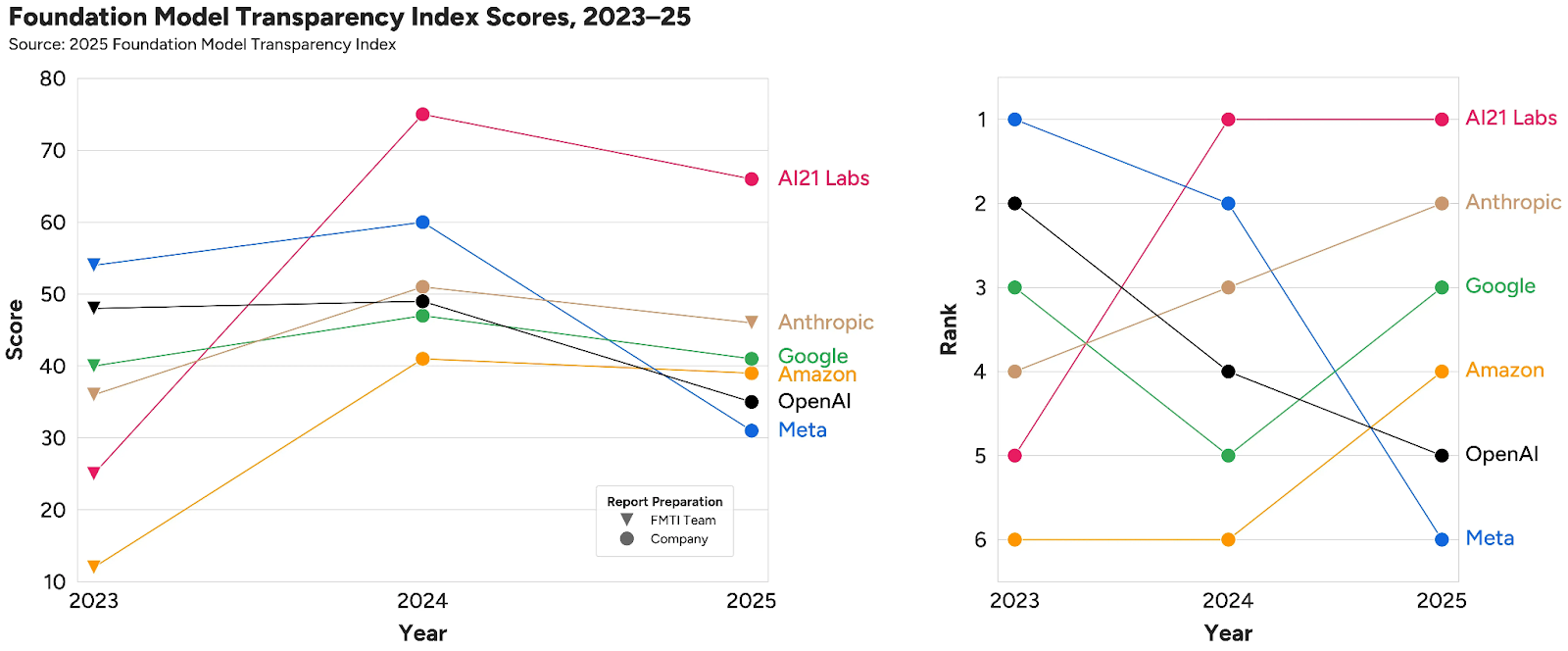

基础模型透明度指数自 2023 年起开始追踪透明度,2025 年出现了整体下滑,且头部玩家发生了大洗牌。

基础模型透明度指数自 2023 年起开始追踪透明度,2025 年出现了整体下滑,且头部玩家发生了大洗牌。

这项工作揭示了企业透明度不断变化的状况。由于 AI 生态系统在过去三年中发生了显著变化,2025 年指数首次更新了 2023 年版中引入的原始指标。考虑到标准的这一变化,得分从 2024 年的平均 58/100 下降到 2025 年的 40/100。个别公司的透明度显著下降:Meta 的得分从 60 降至 31,Mistral 的得分从 55 降至 18。2025 年版还首次纳入了四家公司(阿里巴巴、DeepSeek、Midjourney、xAI),其中包括首次纳入的主要中国公司。这些公司的得分均位于指数的下半区。

随着透明度的普遍下降,公司的排名也发生了动荡。在我们每年都评分的六家公司中,Meta 和 OpenAI 在 2023 年分列第一和第二,但现在分别跌至倒数第一和倒数第二。相比之下,AI21 Labs 从 2023 年的倒数第二升至 2025 年的第一。这些得分变化反映了透明度实践的重大变化。Meta 没有发布其 Llama 4 旗舰模型的技术报告。Google 在发布 Gemini 2.5 的模型卡和技术报告方面严重延迟,引发了英国立法者的审查,因为这涉及其公开承诺发布这些文件的信誉问题。

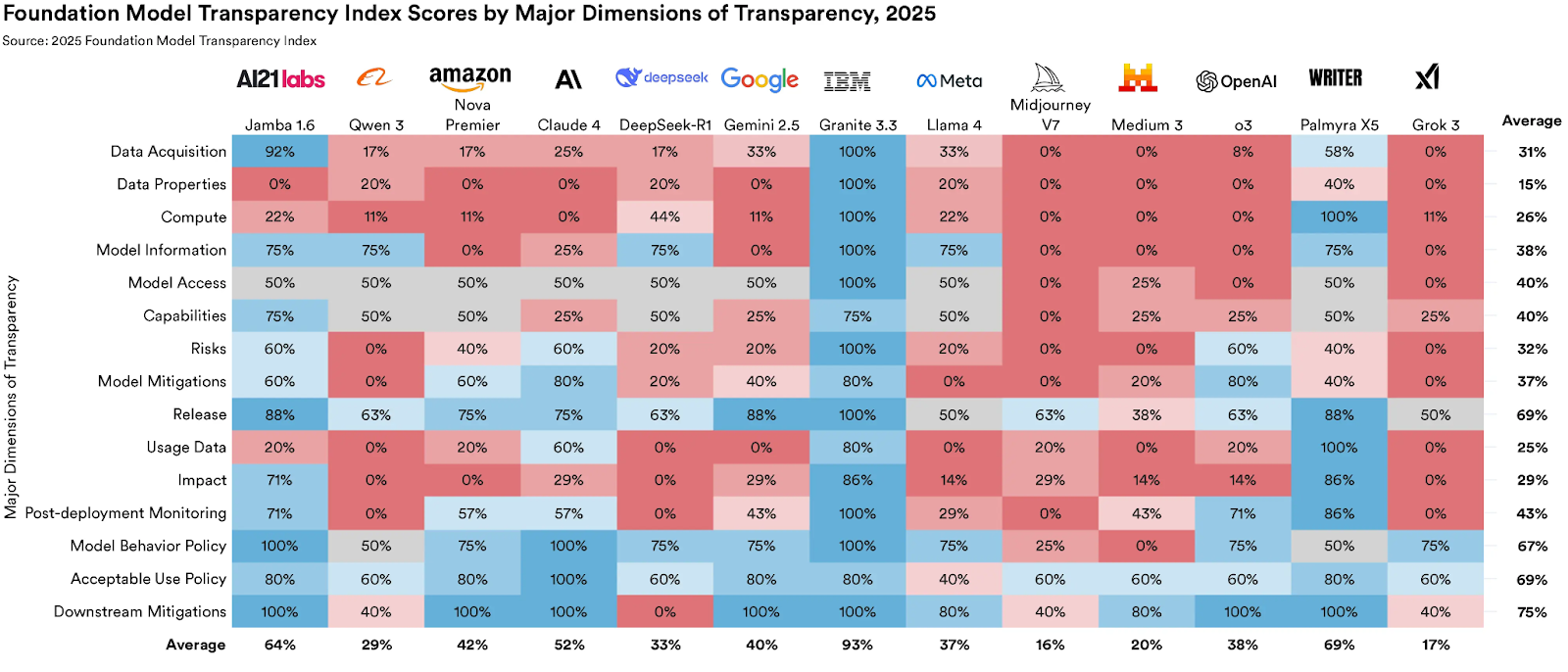

基础模型透明度指数对公司在 15 个主要领域进行评分,包括数据获取、模型访问和部署后监控。

基础模型透明度指数对公司在 15 个主要领域进行评分,包括数据获取、模型访问和部署后监控。

基础模型透明度指数厘清了当前复杂的信息生态系统地形。整个行业在四个关键主题上存在系统性的不透明:训练数据、训练算力、模型的使用方式以及由此产生的社会影响。每一个领域都将基础模型开发商与更广泛的 AI 供应链联系起来。鉴于许多领域在过去三年中一直不透明,今年的指数强调这些领域已成为政策干预的成熟时机。

关于环境影响的信息寥寥无几

公司对构建基础模型的环境影响高度不透明。有 10 家公司没有披露任何与环境影响相关的关键信息:AI21 Labs、阿里巴巴、亚马逊、Anthropic、DeepSeek、Google、Midjourney、Mistral、OpenAI 和 xAI。这包括没有能源使用、碳排放或用水量的信息。随着对数据中心的大规模投资给电网带来压力,导致美国和其他地区能源价格上涨,公司隐瞒这些信息显得尤为重要。

开放并不保证透明;像 DeepSeek 和 Meta 这样主要的开放开发商其实相当不透明。

开放并不保证透明;像 DeepSeek 和 Meta 这样主要的开放开发商其实相当不透明。

开放性与透明度

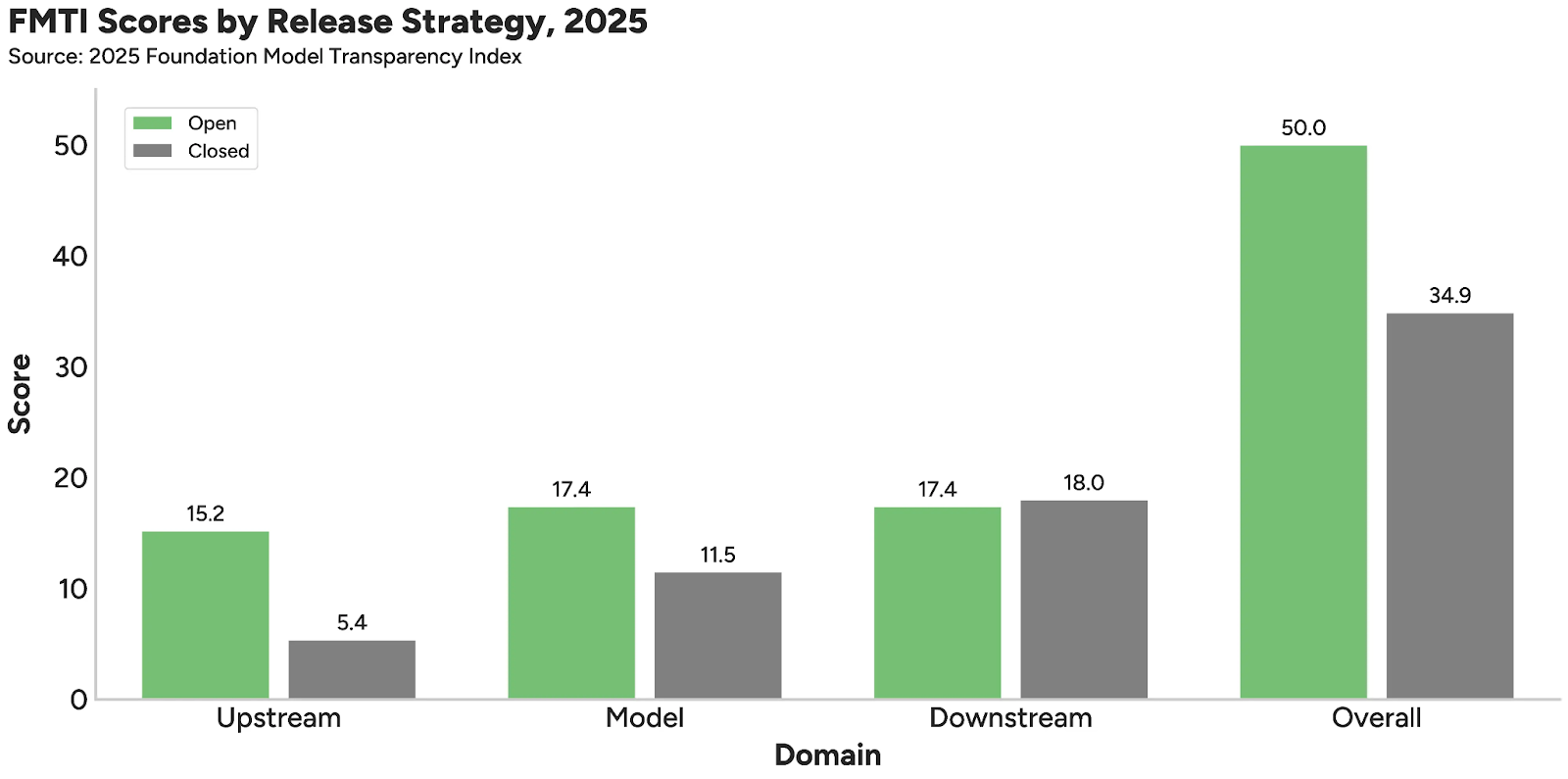

开放性和透明度是两个相互交织的概念,常被混为一谈。为了区分这两个术语,我们将权重公开可用的模型称为“开放”,而如果一家公司向公众披露了有关其做法的重要信息,则称其为“透明”。模型权重的公开发布并不能保证在训练算力、风险评估和下游使用等许多主题上的透明度。从经验上看,开放开发商往往比封闭开发商更透明。

但这种总体效应容易引起误解。虽然 IBM 和 AI21 Labs 这两家开放模型开发商非常透明,但 DeepSeek、Meta 和阿里巴巴这三家最有影响力的开放开发商却相当不透明。在假设开发商发布开放模型权重的选择会带来关于公司做法或社会影响的更广泛透明度时,应持谨慎态度。

展望未来

分享被封锁在 AI 公司内部的信息是一种重要的公共产品,有助于确保公司治理、减轻 AI 带来的危害,并促进对这一尖端技术的有力监督。对更高透明度的总体需求是许多司法管辖区AI 政策的首要任务。加利福尼亚州等地通过了法律,强制要求围绕前沿 AI 的风险进行透明化。前白宫 AI 顾问、《美国 AI 行动计划》主要作者 Dean Ball 提议将透明度措施作为 AI 监管的常识性组成部分。基础模型透明度指数可以作为政策制定者的灯塔,既指出了 AI 行业的当前信息状态,也指出了在缺乏政策的情况下哪些领域更难以随着时间推移而改善。

了解更多关于2025年基础模型透明度指数的信息,浏览每家公司的透明度报告,或阅读描述方法、分析和发现的报告全文。

Shana Lynch 2025年12月15日